Qui sont les premiers chercheurs à avoir travaillé sur les neurones artificiels ?

Question d'origine :

Bonjour cher guichet du savoir,

On lit souvent que l'article "A Logical Calculus of the Ideas Immanent in Nervous Activity" écrit en 1943 par Mc Culloch et Piutts est le premier à parler de neurone artificiel. Or, il n'en est rien. C'est à postériori qu'on a dit cela, le terme ne semblait pas exister à l'époque. Savez-vous qui sont les premières personnes à avoir utilisé ce mot et décrit le fonctionnement de ce modèle ?

Merci.

Réponse du Guichet

Le concept de "neurone formel" introduit en 1943 par deux chercheurs américains, Warren McCulloch et Walter Pitts, reste aujourd’hui un élément de base des réseaux de neurones artificiels (RNA), malgré la simplicité de ce premier modèle mathématique et informatique du neurone biologique.

Ce n'est qu'en 1957 que le premier prototype utilisant des RNA (le perceptron) est développé par Frank Rosenblatt et il faut attendre le début des années 1980 pour que des mathématiciens généralisent le principe d’apprentissage des perceptrons et conçoivent une procédure capable d’apprendre sur des réseaux de neurones à plusieurs couches (la rétropropagation du gradient). Le chercheur français Yann Le Cun, qui travaille depuis les années 80 sur l'apprentissage profond ou deep learning, a continué à perfectionner l’apprentissage sur des réseaux de neurones formels.

Si ce concept mathématique fut l'objet d'un courant de recherche dès les années 1960, il est opérationnel depuis les années 1990, grâce aux progrès effectués dans la compréhension des systèmes non linéaires et aux performances accrues des ordinateurs. Les réseaux de neurones formels, tels qu'ils sont connus et compris actuellement, sont déjà des outils puissants aux multiples applications concrètes mais sont loin d’avoir montré toute l’ampleur de leur potentiel....

Bonjour,

Des moteurs de recherche à la reconnaissance vocale sur nos smartphones, en passant par la prédiction de maladies à partir d’imageries médicales, les réseaux de neurones artificiels (RNA, nommés également neurones simulés ou neurones formels) sont des modèles d'IA qui se révèlent être déjà des outils polyvalents et puissants. Qui sont les premières personnes à avoir utilisé cette notion et décrit le fonctionnement de ce modèle ?

Le site de l'ISO, organisation internationale de normalisation, définit la notion de réseaux de neurones artificiels :

Les réseaux de neurones, également appelés réseaux de neurones artificiels ou réseaux de neurones simulés, sont un type d’algorithme d’apprentissage machine inspiré de la structure et du fonctionnement du cerveau humain. Ils se composent de nœuds interconnectés, appelés des neurones. Mais qu’est-ce qu’un neurone ? Pour le dire simplement, les neurones qui composent un réseau de neurones d’IA sont des fonctions mathématiques qui traitent l’information reçue (en bord du réseau, comme les synapses) et produisent en résultat une valeur numérique (selon que le neurone est activé ou non). [...]

Longtemps restés à l’état de concept, les réseaux de neurones sont aujourd’hui une technologie qui vient révolutionner toute une variété d’industries. La polyvalence et la puissance qui les caractérisent permettent de multiples applications concrètes qui transforment déjà la manière dont nous utilisons la technologie et dont nous interagissons avec.

Ils peuvent par exemple analyser de grandes quantités de données financières et formuler des prédictions concernant les tendances du marché boursier, la solvabilité ou encore la détection des fraudes. [...] Dans le secteur de la santé, les réseaux de neurones sont employés pour le diagnostic des maladies, la découverte de médicaments et la médecine personnalisée [...] Les véhicules autonomes représentent un autre domaine d’application des réseaux de neurones, surtout pour la détection d’objets, la navigation et la prise de décision en temps réel, mais également pour l’expérience utilisateur. Dans le secteur des services, les chatbots optimisés par l’IA bénéficient grandement des réseaux de neurones qui permettent la reconnaissance d’entité, le traitement du langage naturel et l’analyse des sentiments. [...]

Source : Intelligence artificielle : une technologie en pleine évolution (site de l'ISO)

L'Encyclopédie universalis retrace l'historique de ce concept mathématique qui fut l'objet d'un courant de recherche dès les années 1960, avec une mise en sommeil entre 1970 et 1980 puis un regain d'intérêt à partir de 1982, pour devenir opérationnel depuis les années 1990 :

Les réseaux de neurones constituent un avatar récent d'un vieux rêve : celui de la « machine intelligente », susceptible d'imiter – et, bien sûr, de dépasser – les capacités du cerveau humain. Dès les années 1960, un courant de recherche dans ce domaine s'est développé aux États-Unis, mais ses travaux ont rapidement été limités par deux facteurs : la faible puissance des ordinateurs disponibles et, surtout, l'absence des outils conceptuels nécessaires pour analyser et prévoir le comportement des réseaux de neurones formels étudiés à cette époque. Entre 1970 et 1980, ces recherches ont été mises en sommeil, tandis que se développait une nouvelle branche de l'informatique, connue à présent sous l'expression d'intelligence artificielle. À partir de 1982, les réseaux de neurones formels ont connu un regain d'intérêt ; ils sont devenus opérationnels depuis les années 1990, grâce aux progrès effectués dans la compréhension des systèmes non linéaires et aux performances accrues des ordinateurs.

Du point de vue de l'histoire des techniques, le développement récent des réseaux de neurones formels constitue un paradoxe intéressant et exemplaire. Les rares chercheurs et ingénieurs qui, au début des années 1980, se sont lancés dans cette aventure, faisaient le pari qu'il était possible de découvrir des méthodes originales et puissantes de traitement de l'information en imitant ce que l'on pensait savoir du fonctionnement des systèmes nerveux vivants. Ce pari est gagné : les réseaux de neurones formels, tels qu'ils sont connus et compris actuellement, sont des outils puissants pour effectuer certains traitements de l'information ; néanmoins, ce succès ne doit rien à l'inspiration « biologique », mais plutôt à des propriétés mathématiques qui seront décrites plus loin.

Source : Réseaux de neurones, article écrit par Gérard DREYFUS, Professeur à l'E.S.P.C.I.

Toujours dans l'Encyclopédie universalis, l'article Apprentissage profond ou deep learning, écrit par Jean-Gabriel Ganascia, professeur des Universités à la faculté des sciences de Sorbonne université à Paris, revient sur l'histoire du concept de réseaux de neurones formels en indiquant que si Walter Pitts et Warren McCulloch sont les pères du concept, ce n'est qu'en 1957 que le premier prototype utilisant des RNA (le perceptron) est développé par Frank Rosenblatt et il faut attendre le début des années 1980 pour que des mathématiciens généralisent le principe d’apprentissage des perceptrons et conçoivent une procédure capable d’apprendre sur des réseaux de neurones à plusieurs couches (la rétropropagation du gradient) :

L’histoire des réseaux de neurones formels remonte à 1943, avant même la construction des premiers ordinateurs électroniques, alors que l’on commence seulement à fabriquer des calculateurs électromécaniques au moyen de relais téléphoniques. L’idée de dresser un parallèle entre ces machines et le cerveau humain traverse les pensées du mathématicien américain Walter Pitts (1923-1969) qui, âgé d’à peine vingt ans à l’époque, écrit avec le neurophysiologiste américain Warren McCulloch (1898-1969), un article intitulé « A logical calculus of immanent ideas in nervous activity » (« Un calculateur logique des idées immanentes dans l'activité nerveuse »). Ils y établissent une analogie entre, d’un côté, ces relais téléphoniques et les cellules du cerveau – les neurones – et, d’un autre côté, les connexions entre ces relais téléphoniques et les liaisons dites synaptiques qui relient les neurones entre eux. Pour résumer ces analogies, on appelle « neurones formels » ces relais téléphoniques, et « synapses formelles » leurs connexions. Afin de mimer les phénomènes biologiques dits de « plasticité synaptique » qui affectent la plus ou moins grande connectivité de l’influx nerveux entre les neurones et qui se trouvent à l’origine de l’apprentissage physiologique, on module les synapses formelles d’un nombre plus ou moins grand que l’on appelle le « poids synaptique » et qui joue sur l’intensité de la transmission d’information entre les neurones formels. [...]

Toutefois, même si de tels réseaux de neurones formels organisés en trois couches permettent de réaliser n’importe quelle fonction logique, il convient de configurer les liaisons synaptiques entre les neurones formels, autrement dit d’associer à chacune de ces liaisons un nombre, ce qui serait extrêmement fastidieux, voire inextricable manuellement, si l’on ne disposait pas de procédures d’apprentissage. On cherche donc, dès le début des années 1950, à élaborer des techniques pour établir automatiquement les pondérations des liaisons entre les synapses formelles en mimant les phénomènes d’apprentissage neuronal. [...]

En 1957, un psychologue américain, Frank Rosenblatt (1928-1971), met au point un algorithme d’apprentissage pour des réseaux de neurones formels à deux couches qu’il appelle des « perceptrons », car ils reproduisent selon lui les capacités de perception des rétines. Or, si Walter Pitts avait bien montré que les réseaux de neurones à trois couches pouvaient réaliser n’importe quelle fonction logique, il n’en va pas de même pour les réseaux à deux couches, tant s’en faut. En 1969, Marvin Minsky (1927-2016) démontre que la procédure d’apprentissage décrite par Frank Rosenblatt n’apprend que des fonctions très simples, dites linéairement séparables. [...]

Il a fallu attendre le début des années 1980 pour que des mathématiciens généralisent le principe d’apprentissage des perceptrons et conçoivent, en s’inspirant de principes mathématiques issus de la physique statistique, une procédure capable d’apprendre sur des réseaux de neurones à plusieurs couches. En termes techniques, on appelle cette procédure la rétropropagation du gradient. Quelques années plus tard, d’autres mathématiciens cherchèrent à déterminer les fondements théoriques de cet apprentissage avec, entre autres, la théorie statistique de l’apprentissage. Cela les conduisit à développer d’autres techniques d’apprentissage supervisé inspirées des principes mathématiques de l’apprentissage sur les réseaux de neurones formels [...]

En parallèle, des chercheurs comme le Français Yann LeCun continuent avec ténacité à perfectionner l’apprentissage sur des réseaux de neurones formels. Pour cela, ils recourent à la grande puissance de calcul des machines, à un très grand nombre de liaisons synaptiques – de l’ordre de plusieurs centaines de milliers, voire de quelques millions – et surtout à de multiples couches de neurones formels – entre 10 et 15 – dont certaines restent « figées » – en ce sens que les poids des liaisons synaptiques les connectant à d’autres couches y demeurent fixes – tandis que d’autres évoluent par apprentissage. En raison de cette multiplicité de couches, on caractérise ces techniques comme de l’apprentissage profond [ou deep learning] [...]

BibliographieW. Mc Culloch & W. Pitts, « A logical calculus of the ideas immanent in neuron activity », in Bulletin of Mathematical Biophysics, 1943

Y. LeCun, Y. Bengio & G. Hinton, « Deep learning », in Nature, vol. 521, 436-444, 2015

M. Minsky & S. Papert, Perceptrons, MIT Press, Cambridge (Mass.), 1969

F. Rosenblatt, « The perceptron: A probabilistic model for information storage and organization in the brain », in Psychological Review, vol. 65, no 6, 386-408, 1958.

La définition du Larousse attribue également la paternité du concept de neurone formel aux chercheurs américains, Warren McCulloch et Walter Pitts :

Le concept de « neurone formel » encore utilisé date de 1943. Il a été proposé par deux chercheurs américains, Warren McCulloch et Walter Pitts. Le neurone reçoit des entrées, en provenance du monde extérieur, ou en provenance d'autres neurones, il les additionne, et prend une décision. Comme les liaisons ne sont pas directes, on dit que la transmission est modulée, ou « pondérée », par les liaisons. Plus précisément, si le signal transmis d'un neurone à un autre est renforcé, gonflé par la liaison synaptique, on dira que la synapse est excitatrice. À l'opposé, si le signal est affaibli, on parlera de synapse inhibitrice. C'est d'ailleurs ce type de synapse que l'on rencontre en plus grand nombre dans le système nerveux. Un neurone formel reçoit donc des entrées qui sont pondérées par des liaisons synaptiques, et la valeur de ces pondérations dépend de ce que le réseau a vécu. En résumé, un réseau neuronal est un assemblage de multiples neurones qui essaye de garder une trace de ses états successifs, en transformant les liaisons entre ses éléments. [...]

Le site de DataScientest, organisme de formation en Data, Tech, et Cybersécurité, converge dans ce sens :

The mathematical concept of artificial neural networks (ANN) was first introduced in 1943 by two researchers from the University of Chicago, Warren McCullough, and Walter Pitts. In an article for the journal Brain Theory, they presented a theory that focused on the neuron as a fundamental element in responding to external stimuli.

It wasn’t until 1957 that the first prototype utilizing ANNs was developed—the Perceptron by Frank Rosenblatt. It aimed to perform recognition tasks using a repetitive learning algorithm. However, at the time, computers were not sufficiently powerful to process the vast amounts of data required for effective real-world application. This limitation was highlighted by Marvin Minsky and Seymour Papert in their book Perceptrons (1969), where they pointed out the constraints of neural networks. Consequently, research in this area paused for nearly two decades.

A significant breakthrough occurred in 1986 when David Rumelhart, Geoffrey Hinton, and Ronald Williams published a paper on backpropagation, a learning technique that rekindled interest in neural networks.

However, it wasn’t until the advent of Big Data and massively parallel computers that neural networks received adequate processing power. A milestone was achieved in 2012 when Alex Krizhevsky’s team won the ImageNet competition, which focused on image recognition.

Ci-dessous la traduction par Google :

[Le concept mathématique de réseaux de neurones artificiels (RNA) a été introduit pour la première fois en 1943 par deux chercheurs de l'Université de Chicago, Warren McCullough et Walter Pitts. Dans un article paru dans la revue Brain Theory, ils ont présenté une théorie centrée sur le neurone comme élément fondamental de la réponse aux stimuli externes.

Ce n'est qu'en 1957 que le premier prototype utilisant des réseaux neuronaux artificiels (RNA) fut développé : le Perceptron, conçu par Frank Rosenblatt . Il visait à effectuer des tâches de reconnaissance à l'aide d'un algorithme d'apprentissage répétitif. Cependant, à l'époque, les ordinateurs n'étaient pas suffisamment puissants pour traiter les vastes quantités de données nécessaires à une application concrète efficace. Cette limitation fut soulignée par Marvin Minsky et Seymour Papert dans leur ouvrage Perceptrons (1969), où ils soulignèrent les contraintes des réseaux neuronaux. Par conséquent, la recherche dans ce domaine fut interrompue pendant près de deux décennies.

Une avancée significative a eu lieu en 1986 lorsque David Rumelhart, Geoffrey Hinton et Ronald Williams ont publié un article sur la rétropropagation, une technique d’apprentissage qui a ravivé l’intérêt pour les réseaux neuronaux.

Cependant, ce n'est qu'avec l'avènement du Big Data et des ordinateurs massivement parallèles que les réseaux neuronaux ont acquis une puissance de traitement adéquate. Une étape importante a été franchie en 2012 lorsque l'équipe d'Alex Krizhevsky a remporté le concours ImageNet, consacré à la reconnaissance d'images].

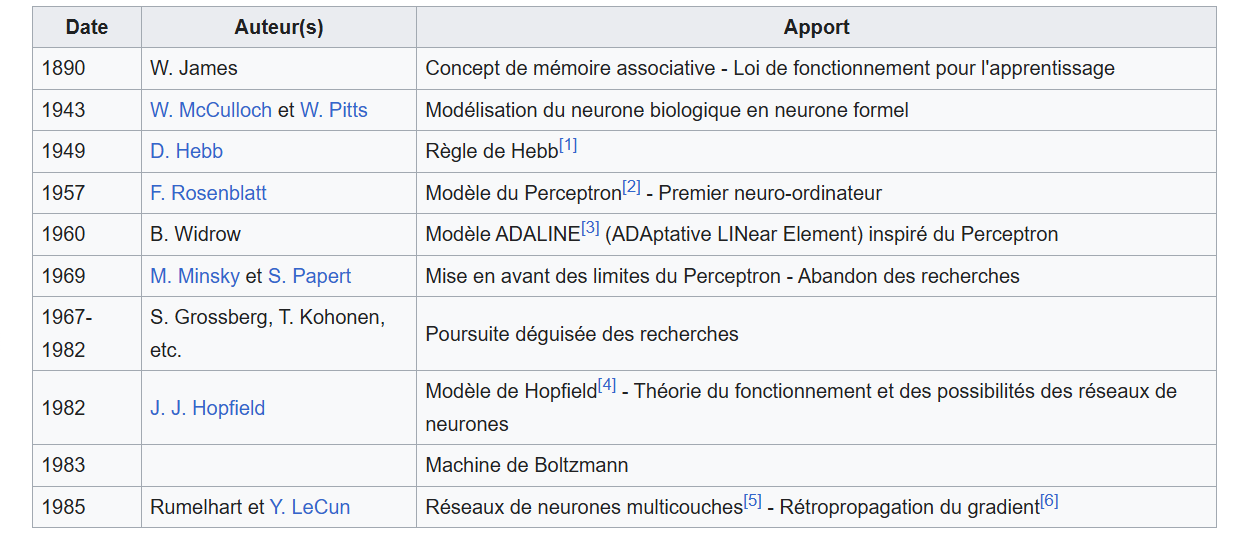

Le site Wikiversité, Réseaux de neurones : Historique, récapitule les dates clés :

Lire également sur le Web :

Réseau de neurones artificiels : réseaux neuronaux pour l'IA (Le site Journal du Net, 2022)

Comprendre les réseaux de neurones (La Revue IA, 2022)

Quèsaco les réseaux de neurones ? (L'IMTech, 2024)

Les réseaux de neurones (France Inter, 2017)

Aux origines de l'intelligence artificielle (France Culture, 2018)

Pour aller plus loin, voici une bibliographie sélective issue de nos collections :

Les réseaux de neurones artificiels [Livre] / François Blayo,... Michel Verleysen,... Collection Que sais-je, 1996

Quand la machine apprend [Livre] : la révolution des neurones artificiels et de l'apprentissage profond / Yann Le Cun ; avec la collaboration de Caroline Brizard, Odile Jacob, 2023

Réseaux de neurones artificiels = Artificial neural networks : comptes rendus / [Livre] / journées d'électronique 1989, Lausanne, 10-12 octobre 1989

La plus belle histoire de l'intelligence [Livre] : des origines aux neurones artificiels : vers une nouvelle étape de l'évolution / Stanislas Dehaene, Yann Le Cun, Jacques Girardon, Robert Laffont, 2018

Réseaux de neurones biologiques et artificiels [Livre] : vers l'émergence de systèmes artificiels conscients ? / Martial Mermillod, De Boeck, 201

Neurones, les intelligences simulées [Livre] : mutations, créations / sous la direction de Frédéric Migayrou et Camille Lenglois, Centre Pompidou, 2020

L'IA, et après ? [Livre] : imiter la raison, former un cerveau, laisser germer la vie : essai / Jean-Michel Truong, 2025

Le cerveau connecté [D.V.D.] / réal. de Ruth Chao ; mus. de Juan Ramon Salgueiro, 2023

Très belle journée à vous

Gender Tech. Ce que la technologie fait au corps des...

Gender Tech. Ce que la technologie fait au corps des...